Instagram测试“裸露保护”功能!自动遮盖私聊中含有色情内容的照片!

Instagram 作为当代年轻人最喜爱的社交媒体之一,让大家分享日常生活,但也又不少滥用者将该平台作为恶意目的的使用,甚至有 Instagram 用户反馈,指自己频频收到了色情内容的私讯,而且这个问题已经持续了蛮长一段时间!对此,Instagram 也在开发一项功能,希望能够通过这项新功能防止用户在私讯当中接收到色情的图片私聊。

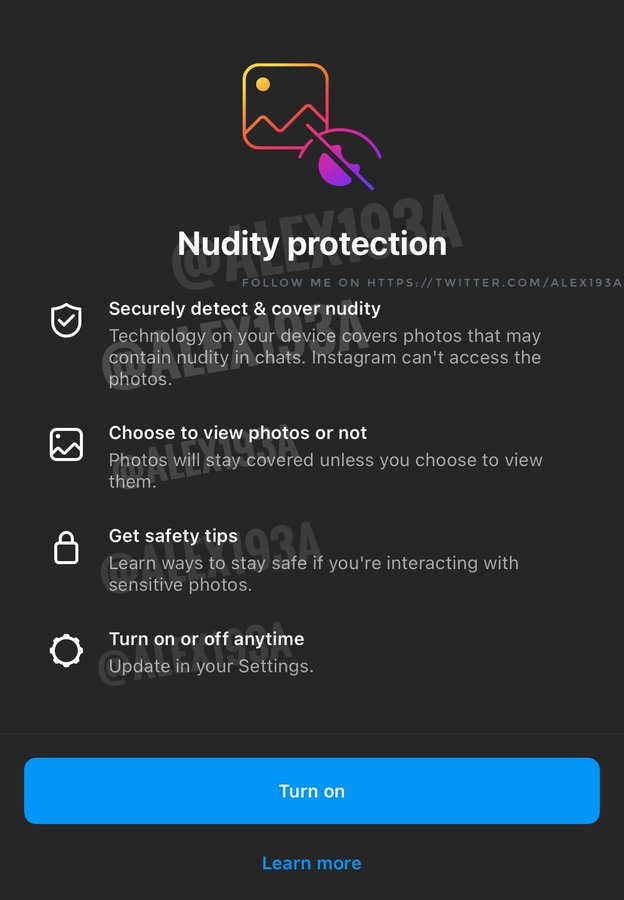

最近,一名开发人员 Alessandro Paluzzi 发现了一个名为 “Nudity Protection” 的功能,并通过 Twitter 发文表示,指该功能将允许系统自动检测可能包含色情元素的图片,并将该照片进行遮挡,若接收者收到该照片时系统也将提供有关下一步可以采取的行动的提示。

既然 Instagram 相关新功能能够允许系统自动检测谈话内容可能包含色情元素的照片,这也意味着用户的隐私或会受到监管。官方对此也表示,Instagram 并不会查看用户发送的照片,而是在评级系统中运行以确保用户的隐私,用户自然也可以选择关闭该功能。

Meta 也向外媒《The Verge》确认,他们将在这几个星期内分享更多有关该功能的详情。

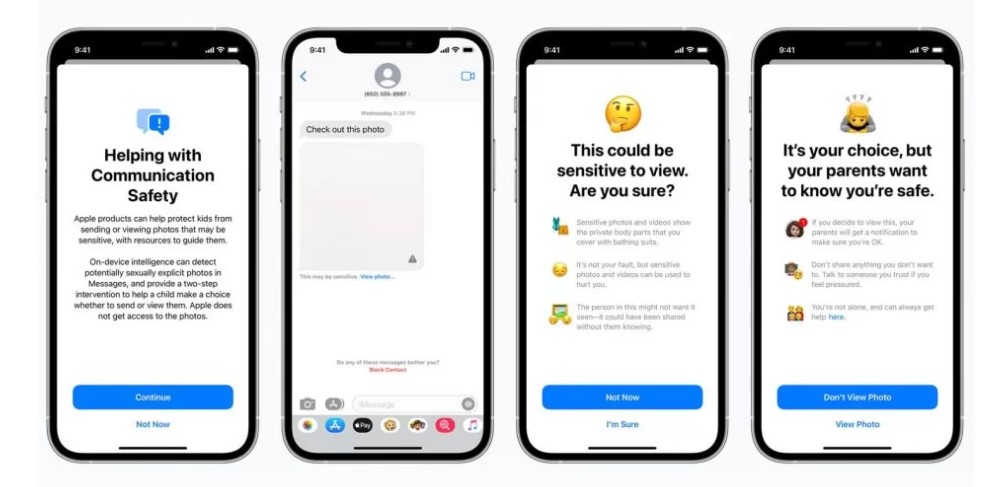

据悉,这类似的私聊筛选系统早在去年 4 月份时苹果就曾推出,以检测未成年用户的设备中的色情内容。也就是说,如果苹果用户收到色情图片,将被一条警告所遮盖,并警告用户该图像可能不适合查看,并建议用户和成年人联系以获得进一步的帮助。

资料来源:Twitter、Amanz