苹果审核iCloud照片风波升温!几年前就已开始“审查”用户iCloud?!

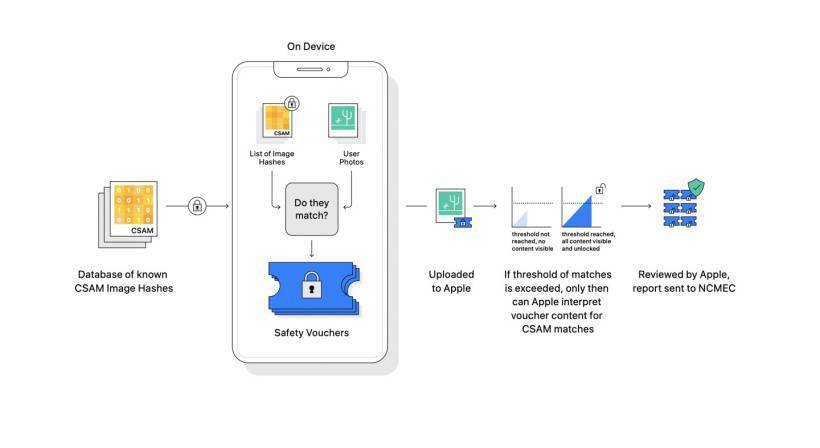

早前苹果承认,将会审核用户手机及iCloud的照片,以辨识“儿童色情和虐待”(CSAM)元素,引起各界抨击,号称最注重隐私的苹果公司形象被质疑。

而事情曝光原由自8月5日,约翰霍普金斯大学Matthew Green教授曝光苹果检测CSAM的技术NeuralHash,能够在用户手机和iCloud或苹果伺服器通过演算法,比对用户照片和CSAM资料库的“杂凑值”,如果对比成功,就会隐藏有关照片,并有可能报警或是通知青少年家长。

(图片来源:苹果)

iOS 14.3就已经植入

机器学习研究者Asuhariet Ygvar也发现,NeuralHash其实在iOS 14.3就已经被植入iPhone系统内,苹果还通过API命名来混淆外界,并在早前宣布表示有关审查CSAM是全新的技术,计划在iOS 15和macOS Monterey正式版才启动。

Ygvar早期测试显示,NeuralHash原算法对照片尺寸和压缩调整抗性比较好,但如果照片经过裁剪或是旋转,就不好用了,也就是说NeuralHash对于审查CSAM效果会打折。波特兰安全研究员Cory Cornelius曾经上传比特犬照片和灰色乱码图,两张毫无关联的图片透过NeuralHash演算法之后杂凑值居然一模一样。

(图片来源:搜狐)

容易被滥用

Github上有人表示,Cornelius的测试结果已经属于原像攻击(pre-image),比“杂凑碰撞”更加严重,杂凑碰撞就是找到两张杂凑值相同的随机照片,原像攻击则可以理解为“刻意碰撞”,也就是指定一张照片,之后生成出量一张杂凑值相同但内容不同的照片。

也有人在标注图片资料库ImageNet找到NeuralHash的“双胞胎”,从ImageNet找到的钉子和滑雪板照片,NeuralHash也能够算出杂凑值相同的情况。

种种迹象显示,苹果力推的NeuralHash原算法有远比人们想象中更严重的滥用缺陷。比如别人可以找一张CSAM照片,生成几张看来无害的照片来,但是杂凑值相同,发送给你,然后你会被苹果举报遭警察调查。

(图片来源:苹果百事网)

2019年开始扫描用户账户

研究员Brad Dwyer说,苹果全球有15亿用户,NeuralHash的错报将会对大量用户造成负面影响。

苹果反欺诈技术部门的负责人Eric Friedman曾经在2020年说,苹果是全世界最大的儿童色情内容平台,意思是苹果隐私安全设计让不少不法分子通过苹果传播这些内容,但如此断言也不禁让人怀疑,当时的苹果有可能已经开始扫描用户照片了?苹果也针对此事回应说,该公司从2019年开始就扫描用户的iCloud账户,那时距离NeuralHash发布时间早了1年。苹果也表示有扫描“其他数据”,但拒绝透露是什么数据,惟当时宣称没有扫描用户的iCloud Photos。

(图片来源:MacRumors)

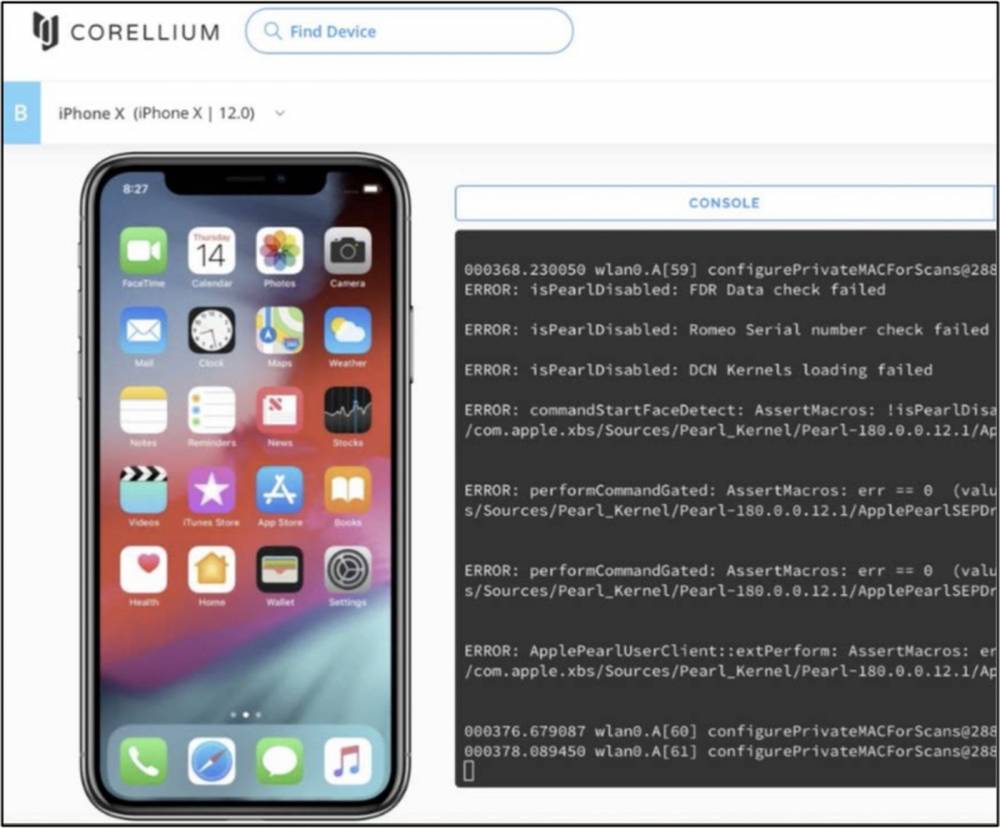

Corellium遭苹果提控

早年,Corellium公司曾经发布“虚拟化ARM框架设备”服务,让用户可以通过电脑研究包括iOS和Android的系统和软件安全,无需购买实体手机。但也因此遭苹果公司提控,但在2020年12月,法官初步判决Corellium没有侵权。这个案件也在8月10日,也就是CSMA扫描争议的几天后庭外和解,不免引起各界联想该公司不像让此案当成与资安对抗的证据。

而在8月17日,Corellium发起了“开放安全计划”招募研究员,主题是“验证设备厂商的安全宣传”,似乎也在针对苹果公司。这件事也激怒了苹果,导致和解协议被取消,对于有关案件再进行上诉。

看来,与苹果公司相关的隐私风波很难有完全落幕的一天。

文章资料来源:TechNews