苹果遭打脸?儿童色情检测功能有漏洞!

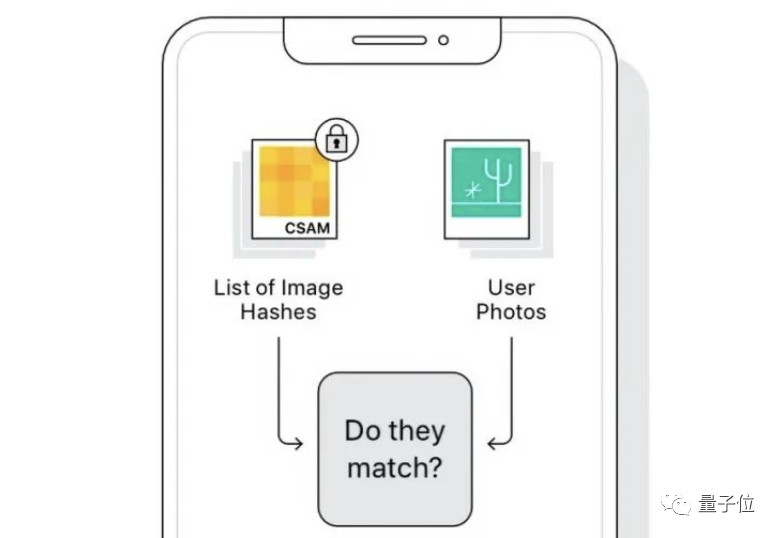

自苹果公司从上周开始推出“儿童安全”功能,对苹果用户们的手机与云端进行扫描以打击儿童色情的内容,虽然此举是为了打击儿童色情活动,加大保护儿童的计划,但却引来维护隐私运动人士的反对,表示他们会因此而失去该有的隐私权。

这个新功能自推出以来就饱受用户的质疑,私隐问题的担忧一度爆发,毕竟相册照片一旦上传到云端,后台的工作人员就能随意查看,用户的不满和焦虑也实属难免。针对这个问题,苹果公司高层也出来再三保证,这项功能完全不会窃取用户的资料,没想到这么快就被打脸了!

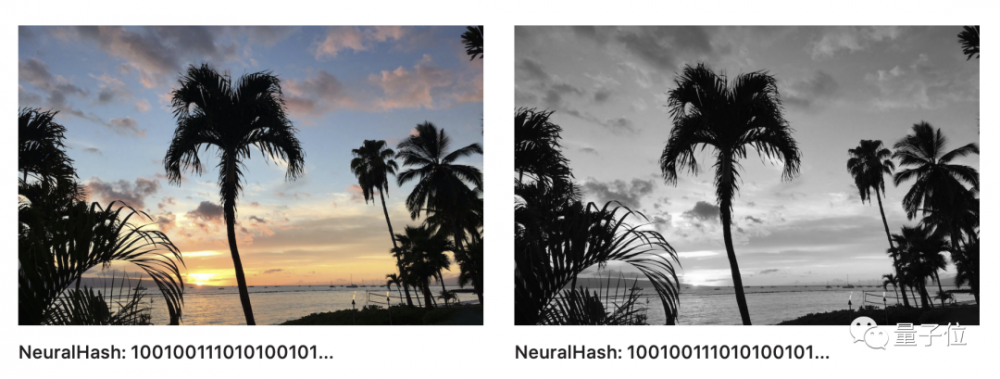

新功能推出不到两个星期,这项技术就被一名名为Asuhariet Ygvar 的程序员给破解了!该名程序员成功将这个尚未正式发布的AI 模型逆向工程,在GitHub 上提供转化成Python 的教程。早在iOS 11.3以及macOS 11.4 开始,他就发现系统中加入了照片检测模型NeuralHash,但尚未启用。因此得出结论,任何可以下载到苹果系统固件的人,就可以轻松将NeuralHash 模型提取出来。

据悉,NeuralHash是一种基于神经网络的图像感知哈希(perceptual hashing)方法。虽然NeuralHash 可以承受图像大小、调整和压缩的变化,但如果图像遭到裁剪或旋转,其哈希值就会产生改变。这就意味着,不法分子可以利用这个渠道来逃过审核。

外媒TechCrunch针对这个漏洞询问苹果公司,但他们却回避了这个问题,强调有人工审核防止该功能被滥用。

资料来源:IT之家