亚马逊产品不是第一次出错! 续Amazon AI建议自杀减轻地球负担后,又爆出别的事?

随着社会越发开明,科技越来越发达,大家不仅仅依赖各种电子产品,还开始使用起各种智能音响或者智能机器人。虽说这样的产品有效于帮助解闷聊天甚至是自动播出自己喜欢的歌曲,但是毕竟所有知识都只是程序,机器人终究不会思考更没有感情,总有出错的时候。

早前来自英国约克郡(Yorkshire)名为莫里特(Danni Morritt)的中年妇女上传了一段关于亚马逊(Amazon)智能音箱的惊人事件。身为医疗人员的Morritt当时想要查一查有关心跳周期(Cardiac Cycle)的资讯并且要求亚马逊的智能助理Alexa朗读出维基百科(Wikipedia)内的资讯。事发时,Morritt不仅仅被吓坏,完全难以置信亚马逊的产品竟然这么“粗鲁还暴力”,还一而再再而三地重新确认语音内容,还亲自上网查询确认原文内容并没有提到这种“自杀”提议。

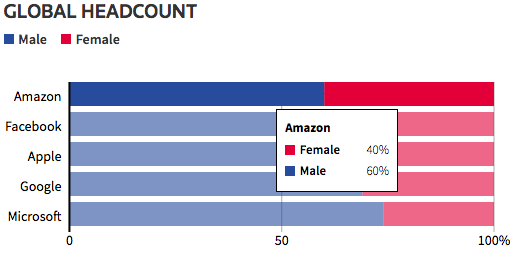

当然这已经不是亚马逊产品第一次出错了,而且当时连亚马逊的产品都会重男轻女!早前亚马逊于2014年到2017年之间为了减轻HR部门的负担决定推出人工智能招聘的软件来帮助审查面试者的简历,帮助提出一些建议。然而,这个软件因为过去十年里的培训和试用期都是以大部分男性的简历进行的,所以自动降低了简历中“女性“的己别,对男性更加有利。

当然,发现这个bug的亚马逊最终放弃使用这个软件,但是当时该公司并没有否认自己使用这个软件来提供意见,但是他们澄清自己没有使用它来评估面试者。虽说科技发达进步,但是仍然有出错的概率。对此你又怎么看呢?现在留言跟我们来谈谈~